Ansatte deler bedriftsdata med AI

En rapport fra IBM viser at chatboter sluker bedriftsdata.

AI-tjenestene er et risikomoment for bedrifter.

IBMs Cost of a Data Breach Report 2025 viser at 13% av organisasjoner opplevde databrudd via AI.

97% av disse virksomhetene manglet tilgangskontroller for AI.1 IBM

- Les mer om personvern

Hvorfor er det et problem?

Det du skriver inn i chatboter brukes til å trene AI. Dermed kan andre brukere og konkurrenter hente ut dine data.

«We can use your Content worldwide to provide, maintain, develop, and improve our Services (…)»

– OpenAIs europeiske brukervilkår2 EU Terms of Use

Fem måter å stoppe dataflukten på

◆ Risikovurdering

Informasjonen nedenfor er ikke juridiske råd.

Gjør alltid en risikovurdering før dere tar i bruk AI-tjenester.

1. Bruk bedriftsabonnement

Som gratisbruker brukes dataene dine til å trene AI.

Bedriftskunder betaler for kontroll over egne data.

Flere populære AI-tjenester tilbyr bedriftsabonnement:

Disse sikrer at kundedata ikke brukes til å trene modellene.

«Dataene dine tilhører deg, og de brukes ikke til å lære opp eller forbedre Gemini-modeller»

– Google6 Workspace

2. Ha en databehandleravtale

En databehandleravtale (DPA) definerer hvem som gjør hva med dataen, og hvem som har ansvaret hvis noe går galt.

Hvis du bruker en ekstern leverandør som OpenAI, Microsoft eller Google, er det lurt med en databehandleravtale.

Leverandører som OpenAI har prosedyrer for å lage avtaler via nettsidene deres.7 Enterprise Privacy

I tillegg har Datatilsynet maler på norsk og engelsk.

Avtalen inneholder (blant annet):

- Når og hvordan persondata skal slettes eller returneres når kontrakten avsluttes

- Krav til underbehandlere som leverandøren bruker

- Sikkerhetsrutiner for kryptering og tilgangskontroll

- Rutiner for overføring av data til andre land

◆ GDPR-krav

I følge Datatilsynet er det krav om slike avtaler hvis man behandler personopplysninger.

F.eks. om man bruker en skytjeneste til å lagre eller behandle kundeopplysninger.8 Datatilsynet

3. Kjør åpne modeller på egne servere

Det er faktisk mulig å kjøre såkalte «åpne modeller» på egne servere eller egne maskiner.

Det at modellen er åpen, betyr at den har åpen kildekode og er gratis å bruke.

Da deles ikke dataene med tekgigantene. All data forblir på egne servere.

Her er noen modeller som kan kjøres lokalt:

- Llama 3 (Meta)

- DeepSeek R1 (kinesisk)

- Mistral (fransk)

- Qwen3 (kinesisk)

- gpt-oss (ChatGPT)

◆ Hvordan kjøre modellene lokalt?

Den enkleste måten er å bruke verktøy som LM Studio, Ollama eller Jan.

AIavisen har ikke gjort en risikovurdering av disse verktøyene og oppgir de bare til informasjon.

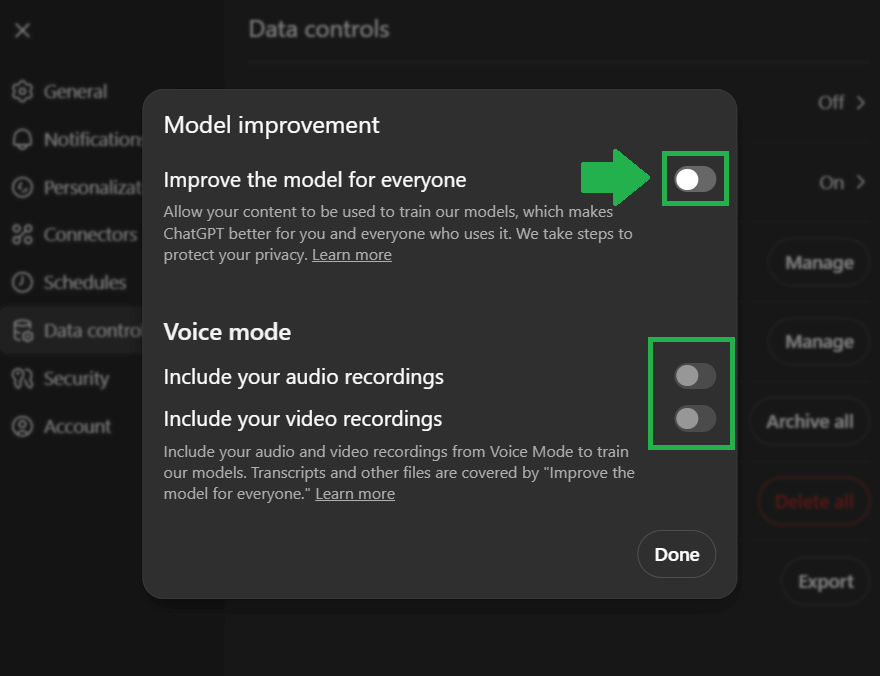

4. Skru av datadeling i AI-verktøyene

De fleste AI-tjenester har innstillinger som lar deg hindre datalagring og AI-trening.

I ChatGPT kan du skru av «Improve the model for everyone» i innstillingene.

- Les guiden: Unngå at ChatGPT bruker dataene dine

OpenAI sletter vanligvis samtaler innen 30 dager.

Men de kan beholde samtaler av sikkerhetsmessige eller juridiske årsaker.

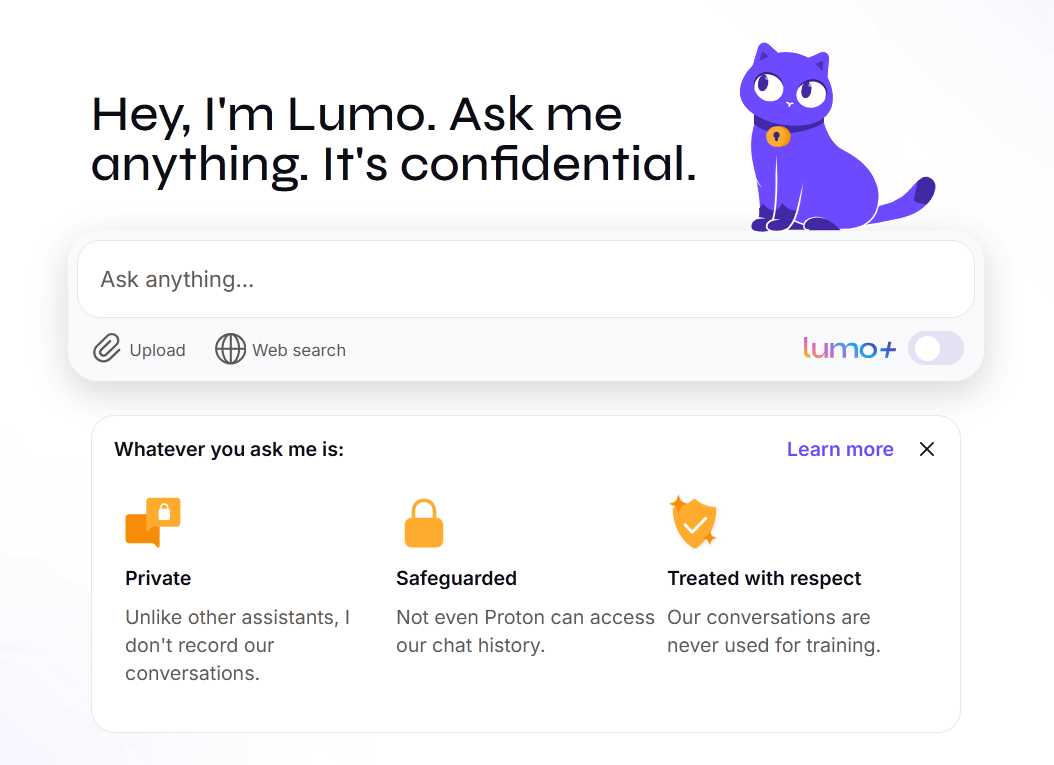

5. Bruk AI som beskytter personvernet

Du kan bruke chatboter uten å miste kontrollen over dataene dine.

Her er to gode alternativer:

Proton – Lumo

I følge Proton så:

- lagres ikke spørsmålene eller svarene dine

- krypteres alt du sender, og Proton kan ikke lese det

- lagres ingenting på serverne

- er koden åpen

DuckDuckGo – Duck AI

Les AIavisens anmeldelse: Test av DuckDuckGo AI Chat

- De fjerner all personlig informasjon

- Underleverandørene får ikke vite hvem du er

- Samtalene dine blir anonymiserte

- Du spores ikke

Ulempene er at disse tjenestene har færre funksjoner enn tekgigantene.

Problemer som kan oppstå

Risikovurdering

Til tross for at du har et bedriftsabonnement og en databehandleravtale, bør man gjøre en risikovurdering.

Eksempelvis er tilgangsstyring helt kritisk hvis AI har tilgang til sensitive bedriftsdata som e-poster og dokumenter.

Dette skriver Datatilsynet og NTNU i sin rapport om Copilot og personvern:

– «Copiloten vil ha tilgang til alle de samme opplysningene som brukeren av verktøyet har. Det betyr at utfordringer og svakheter i «den digitale grunnmuren», som dårlig tilgangsstyring og kontroll over personopplysninger, vil bli synlige og kraftig forsterket av M365 Copilot.» – Datatilsynet9 Rapport

Les brukervilkårene og personvernspolicy

Les alltid over brukervilkårene til eksterne skybaserte tjenester. Det står ansvarsfraskrivelser og viktig informasjon der.

For eksempel:

DuckDuckGo skriver at de ikke lagrer chatteloggene dine i Duck AI.

Men Duck AI bruker underleverandører for AI-modellene (f.eks. OpenAI). Ifølge vilkårene kan de lagre samtalene midlertidig. Nå pågår det en rettssak mot OpenAI som tvinger selskapet til å lagre samtaler permanent.

Det sterkeste leddet

Til tross for at bedriften har et organisert system, databehandleravtale og bedriftsabonnement kan ting gå galt.

La oss si at bedriften abonnerer på M365 Copilot.

Hva skjer hvis de ansatte ikke liker Copilot og foretrekker ChatGPT? Hva skjer hvis de har en gratisbruker og limer inn sensitiv informasjon der?

Det er de ansatte som avgjør om bedriftens tiltak lykkes eller ikke.

Endringslogg